次元削減のための特徴選択の紹介

カリフォルニア工科大学のYoutube動画「次元削減のための特徴選択の紹介」について要点と要約をまとめました

3つの要点

- 要点1

特徴選択は、高次元のデータセットがもたらす課題を軽減し、データ内の重要な関係を明らかにするために重要です。 - 要点2

特徴選択の評価基準には、ラッパーとフィルターの方法があり、それぞれに利点と欠点があります。 - 要点3

特徴選択の検索戦略には、貪欲な前向き探索や後ろ向き削除、焼きなまし法や遺伝的アルゴリズムなどの非貪欲な方法があります。

要約

特徴選択の概要

この講義では、私の名前はDavid Thompsonですが、特徴選択というトピックについて、高次元のデータセットを削減する方法として説明します。特徴選択は、データセットから特徴のサブセットを取り出して、より管理しやすくすることを意味します。特徴選択にはさまざまな方法があり、このモジュールでは、組み合わせ特徴選択技術と情報を提供する特徴の検索戦略を探求します。

特徴選択の重要性

特徴選択が重要な理由はいくつかあります。まず、高次元の入力空間はパターン認識方法にとって課題となることがあります。次元数を減らすことで、これらの課題を克服することができます。また、特徴選択は、データ内の重要な関係を明らかにし、分類や回帰の意思決定に役立ちます。これは解釈のために役立ちます。最後に、特徴選択の目標は、データの次元を削減しながら、タスクに関連する情報を保持することです。

特徴選択の評価基準

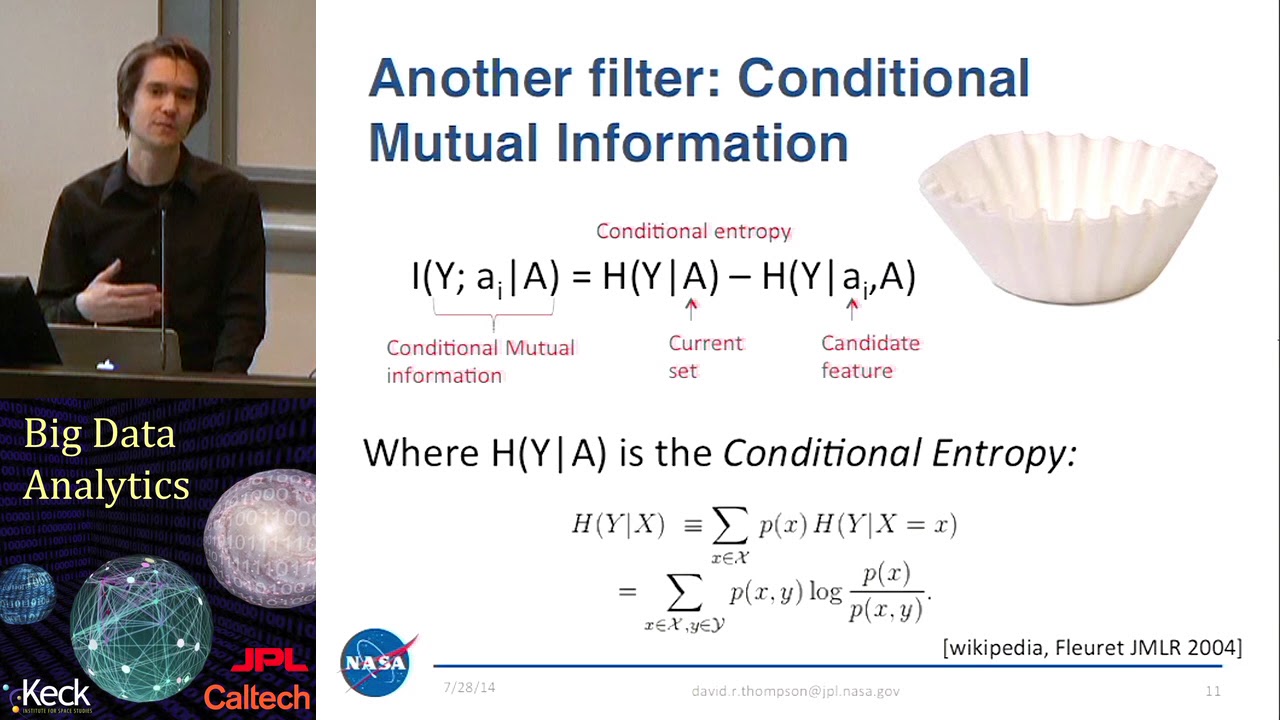

特徴選択には、評価基準と検索ルーチンの2つの要素があります。評価基準には、ラッパーとフィルターの2つの主要なタイプがあります。ラッパーメソッドは、パターン認識エンジンのパフォーマンスを使用して、特徴のサブセットの品質を評価します。一方、フィルターメソッドは、相関や相互情報などの独立したパフォーマンス指標を使用します。各メソッドには、精度と計算量の複雑さなど、利点と欠点があります。

特徴選択の検索戦略

特徴選択の検索ルーチンは、異なる特徴のサブセットがどのように探索されるかを決定します。貪欲な前向き探索は、特徴のパフォーマンスに基づいて1つずつ特徴を追加する一般的な戦略です。貪欲な後ろ向き削除は、特徴のフルセットから始めて、1つずつ特徴を削除していきます。焼きなまし法や遺伝的アルゴリズムなどの非貪欲な探索方法は、代替手法を提供します。各検索戦略には、独自の利点と考慮事項があります。

▼今回の動画

編集後記

▼ライターの学び

特徴選択について学びました。特徴選択は、データの次元削減と重要な関係の抽出に役立つ方法です。

▼今日からやってみよう

今日から特徴選択を実践してみましょう!データセットの次元を削減し、重要な関係を抽出することができます。