Apache Airflowワークフロー管理システムの紹介

カリフォルニア工科大学のYoutube動画「Apache Airflowワークフロー管理システムの紹介」について要点と要約をまとめました

3つの要点

- 要点1

スケーラビリティと柔軟性を備えたワークフロー管理システム - 要点2

Pythonスクリプトを使用してワークフローをプログラムできる - 要点3

幅広いオペレータとセンサーを備えたタスク管理

要約

Apache Airflowの特徴

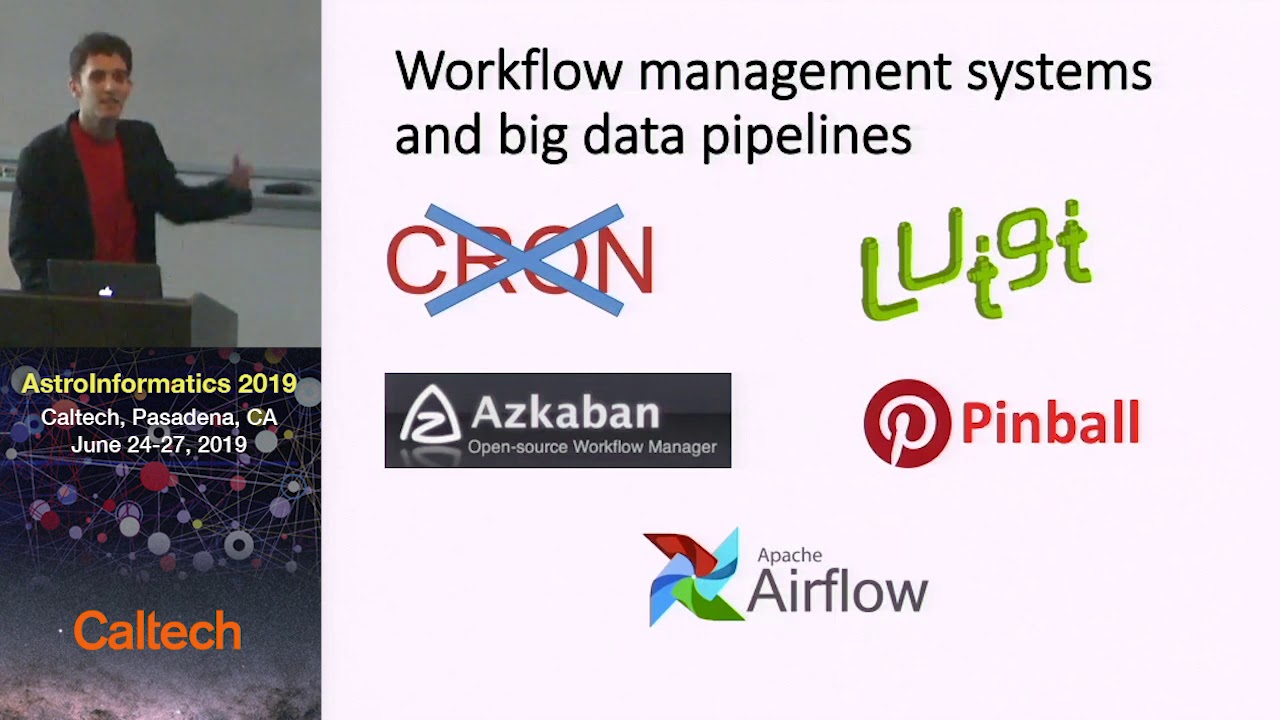

私は博士課程の学生として、プロジェクトでApache Airflowというワークフロー管理システムを使用しています。基本的なcronジョブスケジューラとは異なり、Airflowはよりスマートなスケジューリングとスケーラビリティを提供し、大量のデータや高性能コンピューティングタスクの処理に最適です。現在のデータ処理のニーズに対応すると同時に、将来の成長にも対応するため、インフラストラクチャやエンジニアリングの大幅な変更を必要としません。

Airflowの特徴と他のJavaスケジューラとの違い

多くのワークフロー管理システムがETL(抽出、変換、読み込み)プロセスに焦点を当てている中、Airflowは多様なプロジェクトに使用することができます。Luigi、Azkaban、PinballなどのJavaスケジューラとは異なり、AirflowはPythonスクリプトを使用してワークフローをプログラムすることができます。GitHub上に活発な開発コミュニティと豊富なWeb UIがあり、Airflowはワークフローの可視化と管理に使いやすい環境を提供しています。特筆すべきは、Tesla、Twitter、Yahoo、PayPalなど300以上の企業で公式に使用されていることです。

Airflowの構成要素と機能の理解

Airflowは、タスクが指向され、サイクルがないことを保証するために、有向非循環グラフ(DAG)を使用してワークフローを表現します。パッチオペレータ、Sparkオペレーション、カスタムオペレータなど、さまざまなタスクを実行するための幅広いオペレータを提供しています。さらに、Airflowには特定のイベントが発生するのを待つセンサーもあり、その後のタスクの実行を待ちます。タスク自体がワークフローチェーンの最終コンポーネントです。AirflowのWeb UIでは、DAGをオンまたはオフにしたり、スケジュールしたり、ツリービューやガントチャートを通じて進捗を可視化することができます。

Airflowと高性能コンピューティングおよびログ出力の統合

Airflowは高性能コンピューティングタスクのためにApache Sparkとシームレスに統合されます。ただし、Slurmなどの他のジョブスケジューラの場合、追加の統合が必要な場合があります。Airflowはまた、Web UIを介して実行されたすべてのジョブのログ出力を表示する機能も提供しており、出力ファイルを手動で確認する必要がありません。結論として、皆さんにはApache Airflowを試してみて、自分のワークフロー管理のニーズに合うかどうかを確認していただきたいと思います。

▼今回の動画

編集後記

▼ライターの学び

Apache Airflowについて学んだことは、スケーラビリティと柔軟性を備えたワークフロー管理システムであり、Pythonスクリプトを使用してワークフローをプログラムできるということです。また、幅広いオペレータとセンサーを使ってタスクを管理できます。

▼今日からやってみよう

今日からApache Airflowを試してみて、自分のワークフロー管理のニーズに合うかどうかを確認してみましょう。また、Pythonスクリプトを使用してワークフローをプログラムする方法や、幅広いオペレータとセンサーを使ってタスクを管理する方法を実践してみることができます。